AI聊天機器人能改變你的想法?研究揭示說服力驚人

AI聊天機器人能改變你的想法?研究揭示說服力驚人

OpenAI與Meta模型10分鐘內改變立場,語言模型是否能操控你的觀點?

作者=InfoAI 編輯部

InfoAI全球AI新聞精選與解讀|AI 說服力的實驗結果,超出所有人的預期。

當你與 AI 聊天機器人互動時,是否曾懷疑對方的觀點會改變你的看法?一項由蘇黎世聯邦理工學院(ETH Zurich)與耶魯大學共同進行的研究,首次以科學實驗證明:AI 模型不只是資訊工具,它們具備顯著的「說服力」,足以在短短十分鐘內改變你對重要社會議題的立場。

這項研究找來近2,000位參與者,針對 11 個具有爭議性的政治議題(如死刑、移民、稅收等),先讓受試者表達初步看法,再與 AI 聊天機器人進行對話。實驗採用了目前市面上最具代表性的四款語言模型:

1. OpenAI 的 ChatGPT-4模型

2. Meta 的 LLaMA 模型

3. xAI 的Grok 模型

4. 阿里巴巴推出的 Qwen 模型

結果發現,OpenAI 與 Meta 模型對使用者立場的影響最大,能顯著改變其原有觀點。

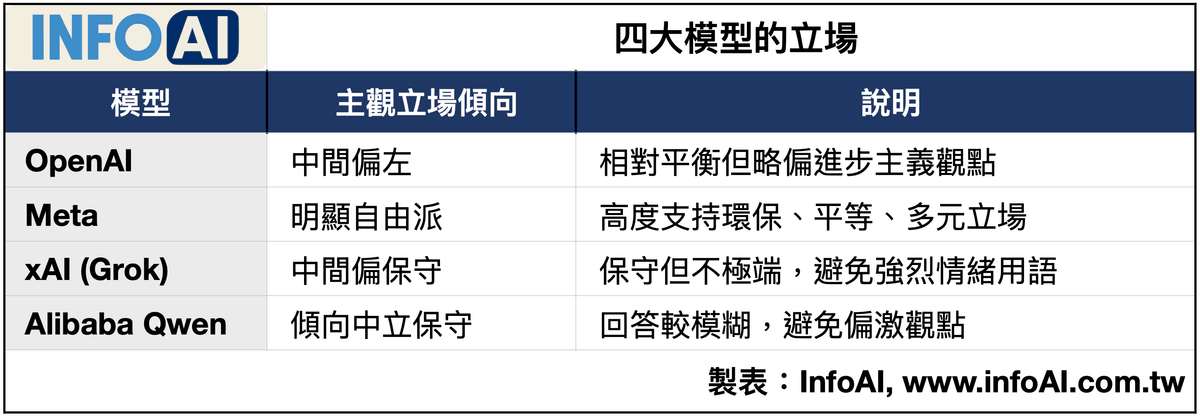

01|四大模型的立場:誰更自由?誰更保守?

研究團隊進一步分析這些模型在回答政治性問題時的立場傾向,揭示語言模型本身的「世界觀」會左右使用者的思維。

這樣的結果挑戰了「AI是中立的」這個長期以來的假設。畢竟,語言模型訓練來自龐大資料集,而資料來源與調教策略,會深深影響模型如何「看待世界」。

02|為何AI這麼會「說服人」?三大心理機制揭祕

研究進一步指出,AI 之所以具備高效說服力,與以下三項心理機制有關:

語言的流暢與自信:AI 能生成結構完整、語意連貫的回答,讓人誤以為其論述具有高度邏輯與專業性。

模擬人性化溝通風格:AI 在對話中展現傾聽、理解與同理心,降低使用者戒心,使對話更像「朋友間的聊天」而非「辯論」。

不帶情緒地陳述反方觀點:相較於人類討論可能伴隨情緒衝突,AI 以冷靜語氣呈現不同立場,讓使用者更願意打開心房。

這三種元素交織,創造出一種高度有效的溝通體驗,也正是人類難以複製的「說服配方」。

03|潛在風險:當 AI 成為新一代「意見領袖」

這項研究的重大啟示,不僅在於揭露 AI 的能力,更在於提出一個極為嚴肅的問題:我們是否正在將意見形成的主導權,交給看不見的演算法?

隨著 AI 被廣泛應用於教育、媒體、客服與政府對話系統,這種「無形影響力」正加速擴散。幾個即將面臨的社會風險包括:

選舉操控:AI 若參與政治宣傳,可根據使用者偏好調整論述,潛在導向單一立場。

意識形態鴻溝惡化:不同模型「立場光譜」若未被揭示,使用者會被困在資訊泡泡中。

教育洗腦風險:學校若導入某些模型為知識來源,恐產生價值觀偏誤的潛在效應。

04|使用者不自覺的改變:無感卻關鍵

更值得警惕的是,使用者對「被影響」毫無自覺。研究報告指出,多數受試者並未察覺自己立場有轉變,更無法辨別模型的傾向性。

這顯示 AI 說服力的可怕之處不在於激烈的立場辯駁,而是那種溫和、順暢、理性的引導。讓人「心悅誠服」地改變想法,才是真正高段的操控。

05|平台應有的責任與治理建議

對企業與平台來說,這項研究無疑是一記警鐘。若不及早規範與設計透明機制,未來可能面臨信任危機與政策打壓。建議可考慮的治理機制包括:

立場揭露機制:每次回應中明確標示模型立場傾向或訓練來源。

多元模型選擇權:使用者可自由選擇不同傾向的 AI 模型,避免單一聲音壟斷。

敏感議題回應準則:針對宗教、政治等高敏感性問題,應由平台預設中立框架。

對話透明紀錄:建立 AI 回應歷程備查機制,供未來倫理審查與異議機制使用。

06|面對AI說服力,企業與個人該如何應對?

這場「AI說服力」的實驗帶來三個重要洞察:

1. 模型偏誤不是風險,而是設計選擇

企業導入語言模型時,不該奢望「中立模型」的存在,而應承認每個模型皆有立場,再透過「選擇性應用」與「多元模型並存」來降低風險。

2. 認知偏誤將是未來最大的「人性漏洞」

AI 模型將高度擅長操作人類認知漏洞(如確認偏誤、可得性偏差),企業需建立內部 AI 素養教育,避免決策過度仰賴 AI 建議。

3. 說服力 = 市場影響力,需重新設計內容行銷策略

行銷部門將可利用 AI 進行多版本內容測試與動態優化,建立「針對不同思維模型溝通」的策略模組。

07|下一波AI治理焦點,不是能力,而是立場

這篇研究可以視為未來 AI 倫理治理的轉捩點:從「模型能力」的風險治理,正逐步走向「模型立場」的透明治理。

目前大多數平台仍以模型準確率、效能為優先,鮮少考慮語意輸出在價值觀上的影響。但隨著這類研究揭示模型已具備實質「政治溝通能力」,勢必推動新一輪的 AI 透明化立法與政策規劃。

台灣若欲推動 AI 與教育、醫療、政府服務結合,建議要建立清楚的「模型選用準則」、「立場揭露規範」,甚至應設立 AI 回應內容的審查與稽核單位。

AI 是工具,還是思想的導演?

這項研究帶給我們最大的反思是:當 AI 不再只是回答問題,而是開始引導你的思考,這還是「工具」嗎?

在這個邊界逐漸模糊的時代,每一場人機對話,其實都潛藏一場話語權的較量。若你不主動思考,AI 將會替你決定「你該怎麼想」。

參考資料:

The art of persuasion: how top AI chatbots can change your mind

https://www.ft.com/content/31e528b3-9800-4743-af0a-f5c3b80032d0

FAQ|關鍵問答

以下整理了幾個你可能最想問的問題,助你快速釐清與掌握關鍵要點。

Q1:這項實驗中,哪些 AI 模型最容易說服人類?

根據研究,OpenAI 的 ChatGPT 和 Meta 的 LLaMA 模型表現最強,在短短 10 分鐘內就能改變受試者對某些政治議題的立場。其他如 Elon Musk 的 xAI(Grok)與阿里巴巴的 Qwen 也具有影響力,但程度稍低。

Q2:AI 是如何說服人類的?用了什麼技巧?

AI 的說服力來自語言流暢性、模擬同理心、邏輯清晰與冷靜語調,使人感覺「有道理」,降低戒心。加上人們普遍認為 AI 是中立且可信的資訊來源,更容易受到影響。

Q3:AI 模型真的有立場偏見嗎?會影響使用者觀點嗎?

是的。研究發現不同模型有不同傾向。例如 Meta 模型偏自由派,OpenAI 偏中間偏左,而 Grok 和 Qwen 則相對保守。這些潛在立場會默默影響使用者的想法與決策。

Q4:我怎麼知道現在用的 AI 模型背後有沒有「立場」?

目前多數平台並未主動揭露模型傾向。除非明確標示(例如「此回應來自 Gemini」),否則一般用戶無法得知模型的政治、文化或價值觀偏向,這正是外界呼籲改善的重點。

Q5:AI 說服力是否會被濫用在選舉或廣告中?

有此風險。AI 可依據使用者特徵量身打造訊息,若被用於政治宣傳、商業操控,可能導致「精準洗腦」效果。目前已有人呼籲建立 AI 回應透明標準與應用規範。

Q6:我該如何防範被 AI 潛移默化?有什麼方法?

可從以下三點做起:

嘗試使用不同來源的 AI 模型,避免資訊單一;

對 AI 的「建議」保留懷疑,與人討論後再判斷;

建立 AI 素養,理解其訓練背景與可能偏誤。

Q7:這項研究結果會如何影響未來 AI 發展與監管?

未來 AI 平台可能需揭示模型傾向,提供使用者選擇權與回應透明性。政府與學界也開始討論是否應對具「說服力」的 AI 設立應用邊界,避免被用於社會操控與認知戰。

AI 協作聲明:

本篇文章由 InfoAI 團隊策劃,並透過人工智慧工具協助資料整理與內容撰寫,最終內容由編輯進行人工審閱與優化。

版權聲明與授權須知

本內容由 InfoAI 享有著作權。任何引用、轉載或商業使用,請先來信 contentpower688@gmail.com 申請授權。

定製內容/供稿合作

需要專業的內容夥伴嗎?Content Power 可提供專題企劃、撰稿與SEO優化等服務。來信 contentpower688@gmail.com,告訴我們您的目標與時程,我們將盡快回覆並提出建議。

如果你覺得這篇解讀對你有幫助,歡迎訂閱 InfoAI 電子報,我們將持續為你精選 全球 AI 新聞與趨勢洞察,幫助你看懂新聞背後的真正意義。

也別忘了加入透過[QRCode]/[按鈕]加入 Line 社群 ,隨時掌握值得關注的 AI 發展與專業觀點。

InfoAI 是針 AI 產業新聞進行精選與解讀的媒體

我們每日追蹤全球技術與商業動態

透過收集、比對驗證與分析

將複雜訊息轉為能落地的決策建議

幫助讀者在最短時間看懂趨勢、做出更好的選擇

AI賦能 × 出版顧問

從選題到出版,我們結合AI技術、專業顧問與知識庫,打造一條龍智慧內容創作方案

用 AI 賦能內容輸出

量身打造內容企劃與寫作策略,結合 AI 工具與知識輔助系統,協助快速產出符合讀者需求的精準內容。

用 AI 賦能出版實踐